2025-03-21ai02门户网

说好的开源周5天,想不到周六还来一个彩蛋,推出了DeepSeek-V3/R1推理系统。

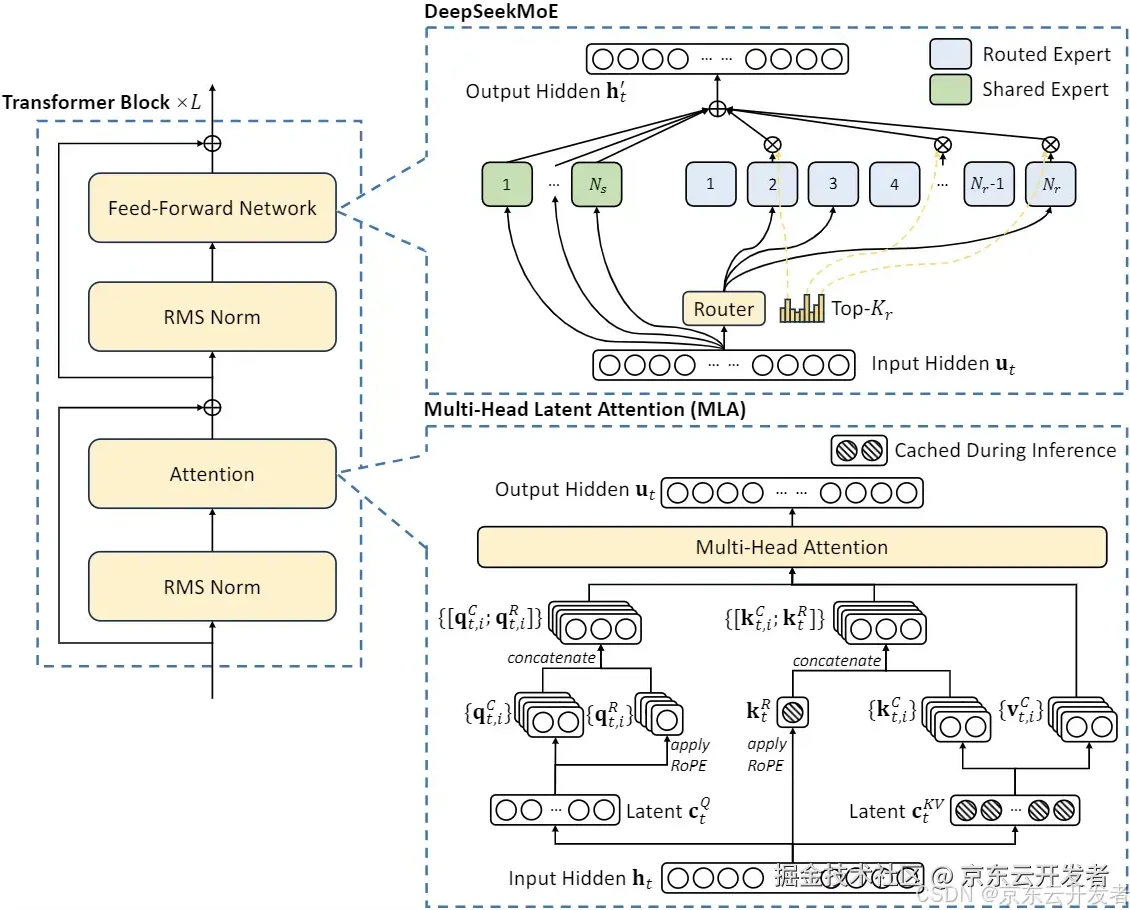

DeepSeek-V3/R1推理系统是DeepSeek最新推出的高性能推理系统,旨在通过优化吞吐量和延迟来提升推理效率。该系统采用了大规模跨节点专家并行(Expert Parallelism, EP)技术,显著提高了GPU矩阵计算的效率,并通过将专家模块分布在不同GPU上来降低延迟。

高吞吐量和低延迟优化:

采用跨节点专家并行(Expert Parallelism, EP)技术,显著扩大批处理规模,提高GPU矩阵计算效率。

通过预填充-解码解耦架构,在预填充和解码阶段分别采用不同程度的并行策略。

智能负载均衡:

在预填充和解码阶段分别实现核心注意力计算和分发发送负载的均衡。

在混合专家模型(MoE)中,平衡每个GPU上的专家计算工作量。

计算-通信重叠处理:

采用dual-batch重叠策略,将同一批请求分割为两个microbatch,以隐藏通信成本并提高整体吞吐量。

在解码阶段,采用五阶段流水线技术,实现计算与通信的无缝重叠。

大规模跨节点专家并行(EP):

每层256个专家中仅激活8个,模型的高稀疏性特点要求采用极大的整体批处理规模。

预填充阶段采用路由专家EP32和MLA/共享专家DP32,解码阶段采用路由专家EP144和MLA/共享专家DP144。

高效资源利用:

在白天高峰时段,所有节点都部署推理服务;在夜间低负载时段,减少推理节点并将资源分配给研究和训练。

跨节点专家并行(EP):DeepSeek-V3/R1模型能够激活大量的专家网络,但每层仅激活256个专家中的8个,生成高度稀疏的计算结构。

负载平衡:系统设计确保各个节点间的计算负载均匀,从而能够有效利用全部资源。

成本和利润率:根据模型的最新评估,假设GPU租赁成本为每小时2美元,总成本为每天87072美元,而理论上的一天总收入可达562027美元,成本利润率高达545%

在线推理服务:

所有DeepSeek-V3/R1推理服务均在H800 GPU上运行,精度与训练保持一致。

提供高吞吐量和低延迟的在线推理服务,适用于网页、APP和API的所有用户请求。

商业化和非商业化服务:

部分服务实现了商业化,网页和APP访问仍然免费。

在非高峰时段自动应用夜间折扣,优化资源利用和成本效益。

在过去24小时内,V3和R1推理服务的合计峰值节点占用达到278个,平均占用226.75个节点(每个节点包含8个H800 GPU)。

每个H800节点在预填充阶段提供平均约7.37万token/秒的输入吞吐量,或在解码阶段提供约1.48万token/秒的输出吞吐量。

如果所有token都按照DeepSeek-R1的定价计费,每日总收入将达到562,027美元,利润率为545%。

第一天:FlashMLA,针对NVIDIA Hopper GPU的高效解码内核,优化了多头潜在注意力(MLA)的性能,显著提升了ai工具在内容创作中的响应速度。

第二天:DeepeEP,首个用于混合专家模型(MoE)训练和推理的开源通信库,优化了大规模分布式训练的通信效率,降低了延迟。

第三天:DeepGEMM,支持稠密和MoE模型的FP8计算库,专为NVIDIA Hopper架构GPU设计,显著提高了计算效率和硬件利用率。

第四天:DualPipe,一种双向流水线并行算法,旨在优化V3/R1模型训练中的计算和通信重叠。EPLB,一个专家并行负载均衡器,专门用于解决大规模AI模型中专家并行任务的负载不均衡问题。

第五天:3FS,高性能分布式文件系统。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表本站立场。文章及其配图仅供学习分享之

新品榜/热门榜